A Apple lançou, em seu repositório no Hugging Face, um novo modelo de inteligência artificial de código aberto para geração de vídeos chamado STARFlow-V [PDF]. Concorrente de modelos como o Stable Diffusion, o Sora (da OpenAI) e o Veo (do Google), ele chega com um diferencial importante em relação a essas plataformas.

É que o STARFlow-V não usa a técnica de difusão (que gera vídeos a partir de ruído em pequenos passos extremamente lentos), e sim uma estratégia já bastante conhecida denominada transformer autoregressive flow, que usa funções invertíveis para gerar vídeos mais rapidamente — e com menos mudanças entre quadros.

Posts relacionados

- Apple publica mais 20 projetos de código aberto focados em inteligência artificial

- DeepSeek lança novos modelos de IA avançados, focados em raciocínio

- Anthropic lança Claude Opus 4.5, o “melhor modelo do mundo” para programação

Nos modelos de difusão, como os diversos frames são tratados simultaneamente de uma única vez ou de forma mais misturada, um erro acumulado deixa a imagem estranha ou borrada com o passar dos segundos — algo que tende a não acontecer com o STARFlow-V, que é considerado um modelo do tipo “causal”.

Apple presents STARFlow-V

— AK (@_akhaliq) December 1, 2025

End-to-End Video Generative Modeling with Normalizing Flow pic.twitter.com/wTxJ5gmVfQ

Modelagem generativa de vídeo de ponta a ponta com Normalizing Flow.

Isso porque o modelo da Apple gera o vídeo sequencialmente (com os frames iniciais sendo responsáveis por ditarem os rumos dos futuros). Como esse processo é contínuo, ele também é “invertível” por natureza, podendo ser usado para três tarefas diferentes sem a necessidade de adaptações ou modelos derivados.

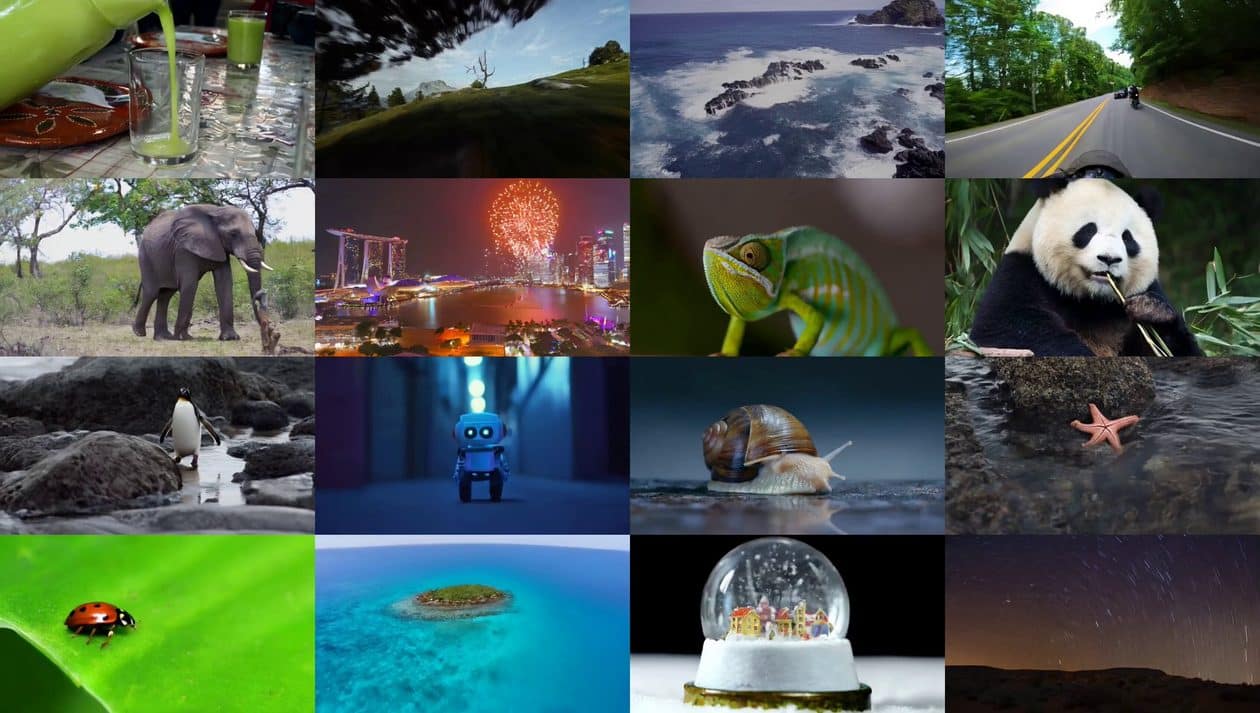

Com o STARFlow-V, é possível gerar vídeos a partir de prompts de texto, de uma imagem estática ou de um outro vídeo usando a mesma base, o que o torna um modelo bastante versátil. Como contrapartida, no entanto, ele ainda pode gerar situações fisicamente impossíveis e exige muito poder computacional.