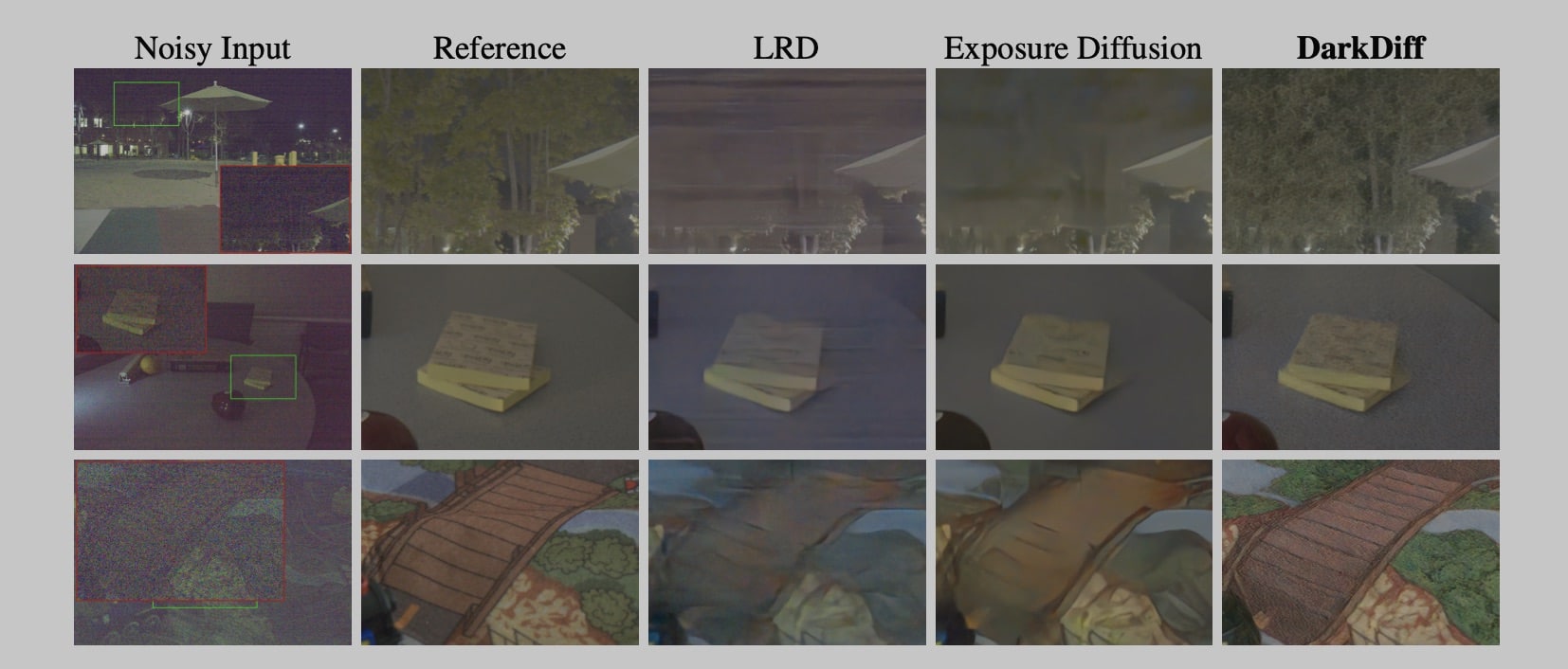

Um novo estudo [PDF] de pesquisadores da Apple e da Purdue University apresentou o modelo DarkDiff, projetado para melhorar a qualidade de fotos capturadas em condições de iluminação extremamente baixas, que geralmente apresentam ruído e outros problemas.

O DarkDiff busca resolver dois grandes sintomas causados pelos modelos atuais de mesmo propósito: a suavização excessiva (que às vezes deixa as imagens com um aspecto de “pintura a óleo”) e a geração de elementos inexistentes (a famosa “alucinação”).

Posts relacionados

- Modelo da Apple transforma fotos 2D em visualizações 3D em tempo real

- Apple revela IA capaz de gerar imagens 3D de ambientes

- Apple lança modelo de IA para vídeos com técnica alternativa à de difusão

Para contornar essas deficiências, o DarkDiff adapta modelos de difusão pré-treinados (como o Stable Diffusion) para trabalhar com dados derivados de imagens brutas da câmera (RAW), fazendo isso por meio de quatro etapas principais.

A primeira delas é um pipeline de dados customizado, no qual os dados crus são convertidos em um formato denominado Linear RGB (LRGB) — o que aproxima a imagem do tipo de dado que o modelo já conhece, facilitando o processamento.

Depois, o modelo implementa a técnica Region-based Cross-attention, em que o modelo foca em pequenos blocos locais da imagem (e não nela toda de uma vez, o que causa as alucinações) para que os detalhes gerados sejam mais precisos.

Na sequência, o modelo utiliza um codificador com conexões residuais para ajudar a preservar a identidade do conteúdo; por fim, é aplicada uma função que penaliza o modelo caso haja desvios cromáticos, evitando mudanças na coloração.

Como resultado, o DarkDiff acaba produzindo imagens com detalhes mais nítidos e cores muito mais precisas em comparação com métodos comuns no mercado, algo que é evidenciado em uma série de testes e imagens apresentados no estudo.

via 9to5Mac